Data mining

[데이터 마이닝] ANN

여뉴누

2023. 6. 18. 19:10

728x90

강의 출처) 2023-1 숙명여자대학교 소프트웨어학부 강의 "데이터마이닝및분석", 이기용 교수님

" Forward Propagation -> Backward Propagation -> gradient descent " 과정의 반복

1. Forward Propagation

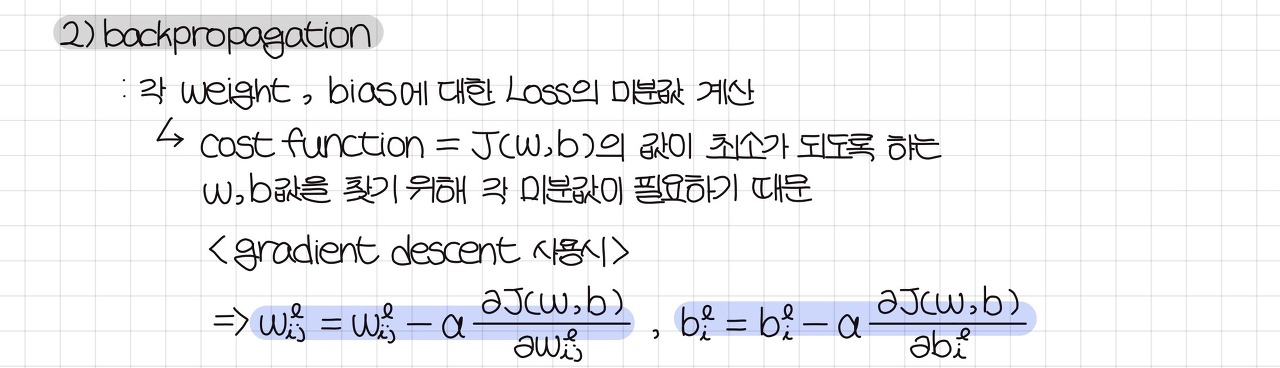

2. Backward Propagation

1) 기본 Concept

-> J(w,b) = objective function 을 최소화시키고자 함

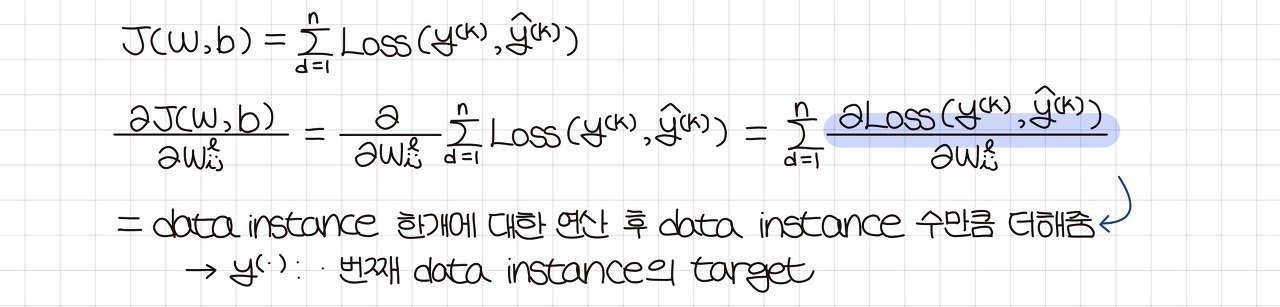

2) Weight에 대해 J(w,b) 미분

-> J(w,b) = objective function 를 최소화하는 weight의 값을 찾고자 하는 것

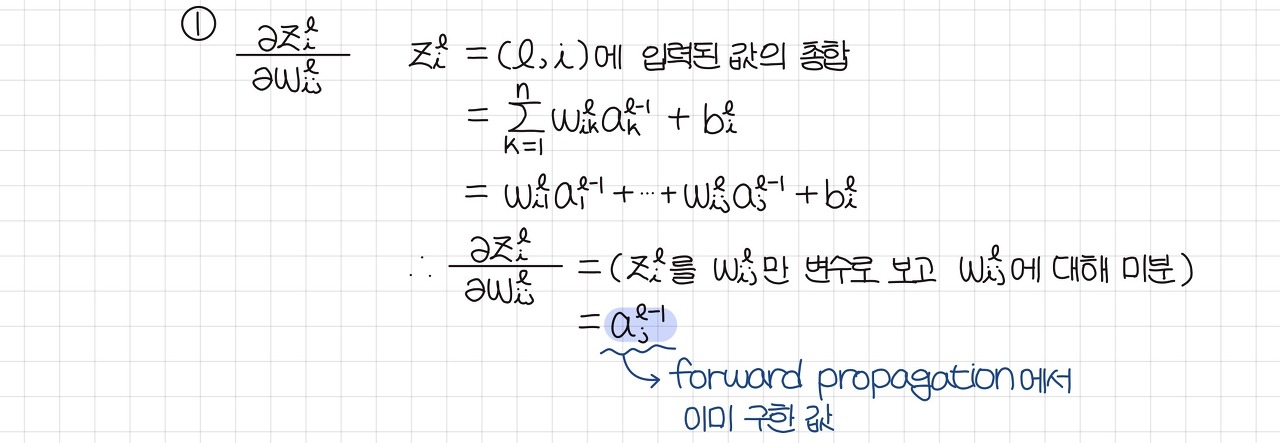

(1) J(w,b) 식을 분할 - 1

(2) J(w,b) 식을 분할 - 2

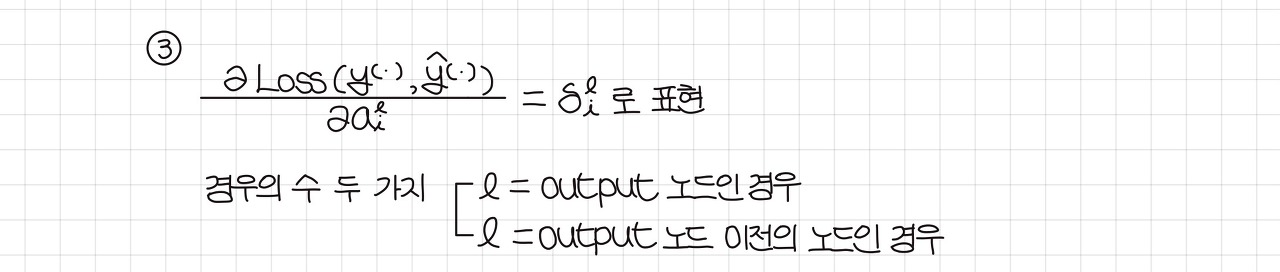

(3) J(w,b) 식을 분할 - 3

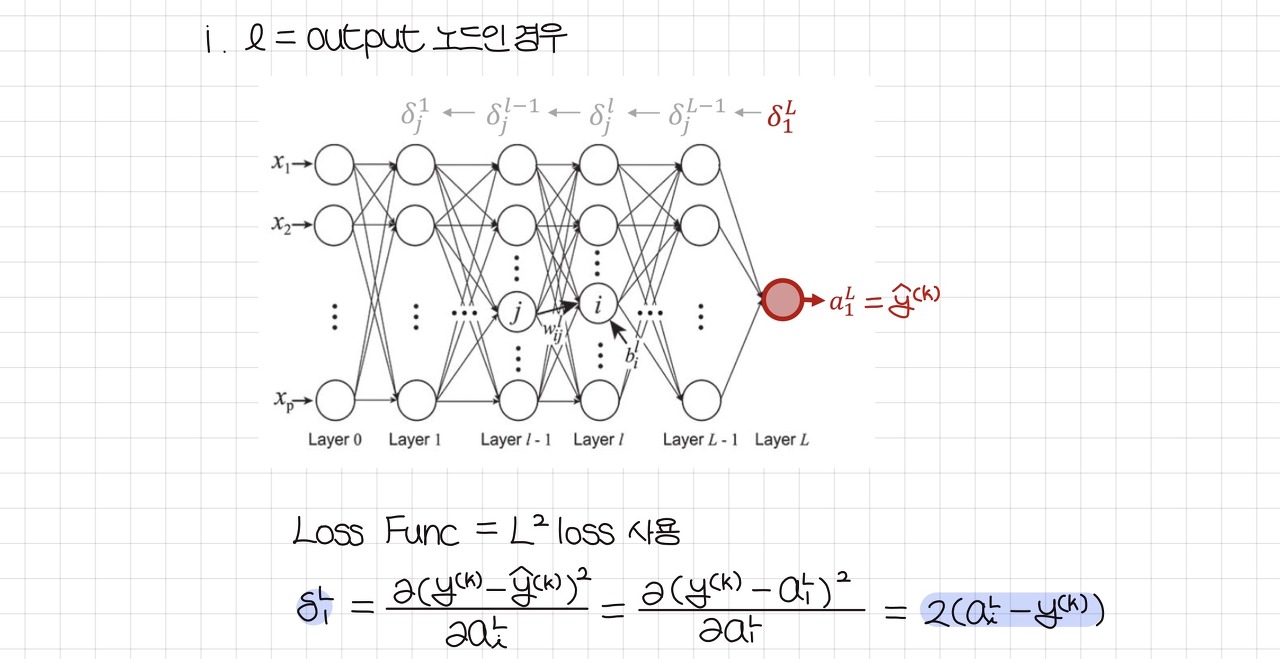

- 구하려는 델타값의 레이어 == output 레이어인 경우

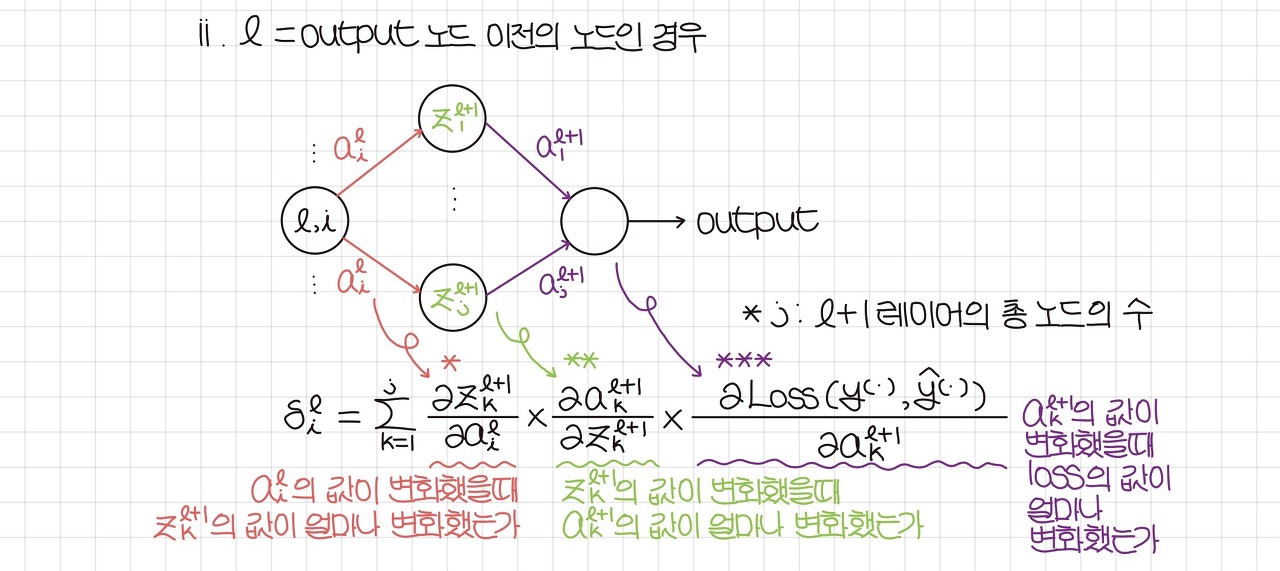

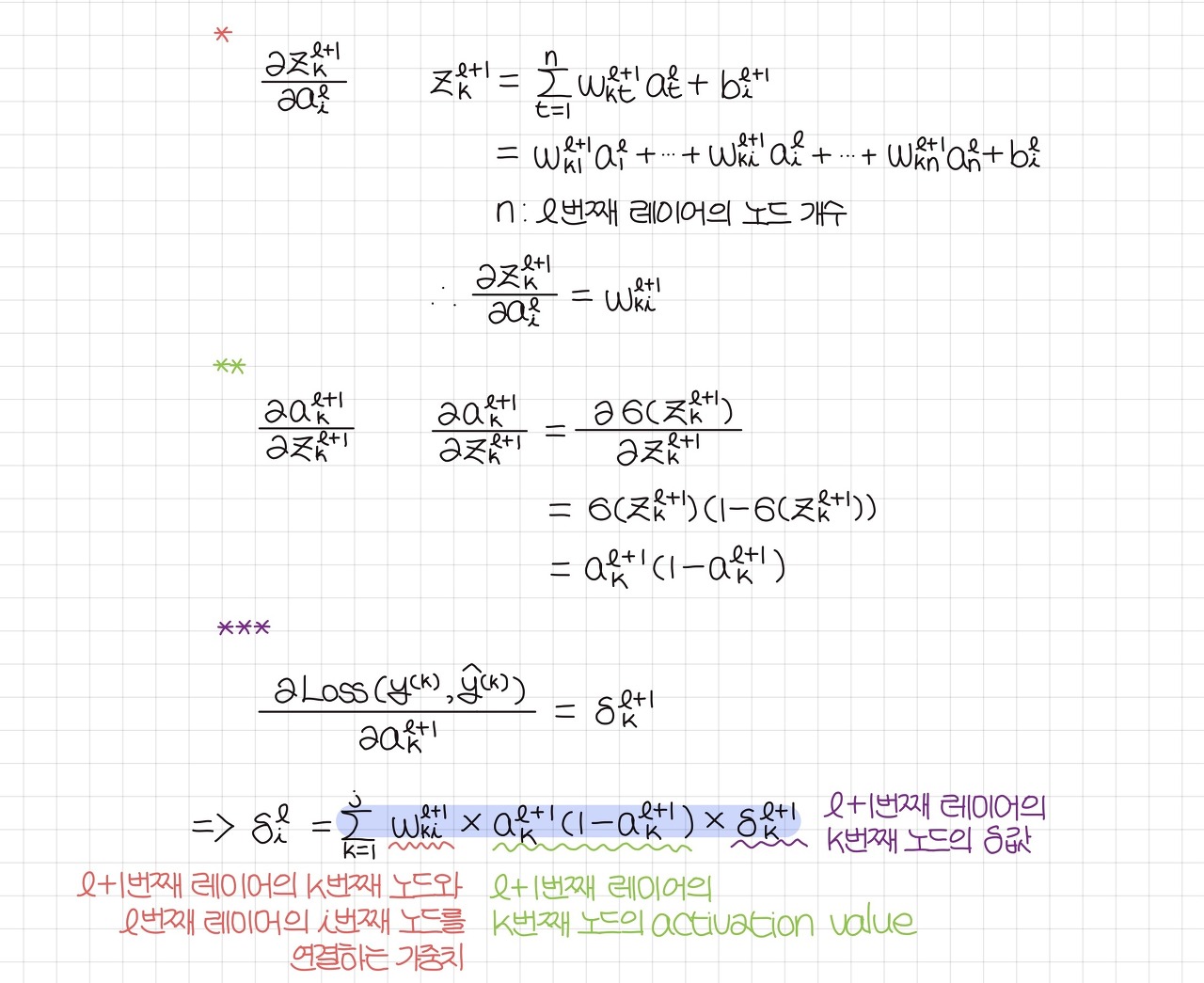

- 구하려는 델타값의 레이어 != output 레이어인 경우

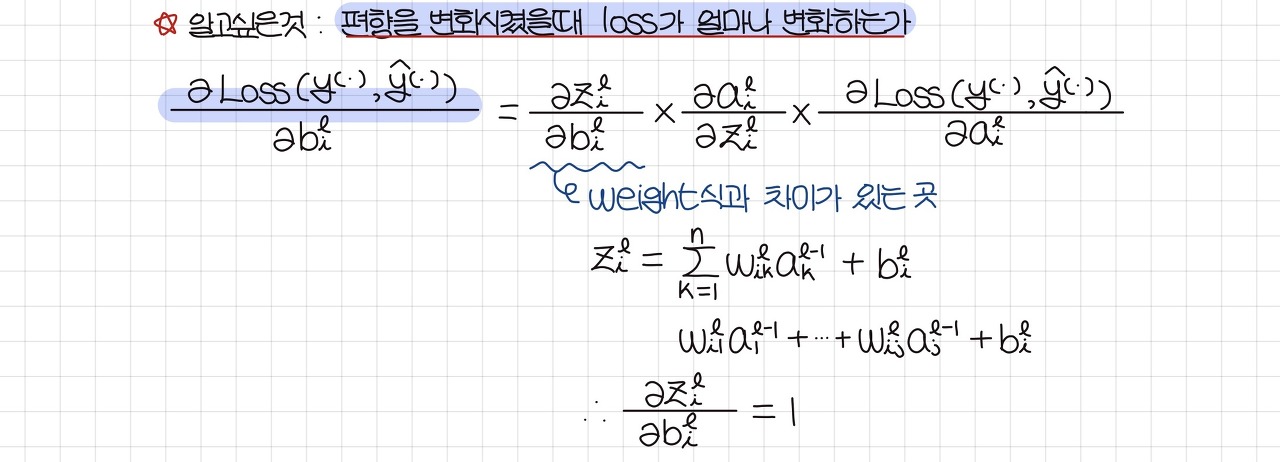

3) Bias에 대해 J(w,b) 미분

-> J(w,b) = objective function 를 최소화하는 bias의 값을 찾고자 하는 것

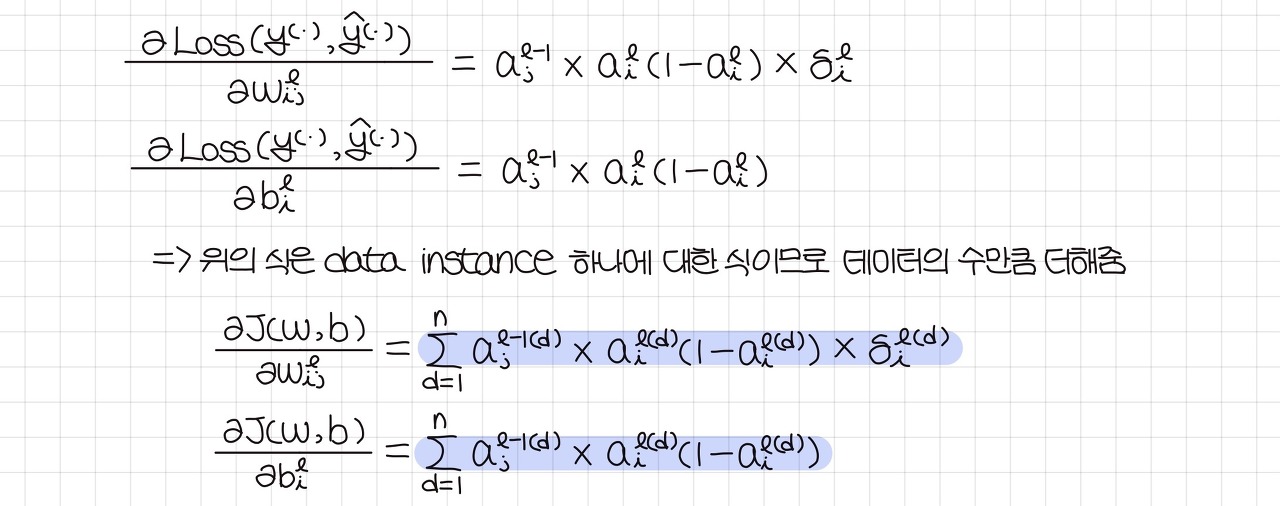

4) Weigt, bias로 미분한 결과

5) 전체 과정 정리

3. Gradient Descent

728x90